연구망 On-premise LLMs 포탈 구축 및 활용사례 안내

크레오넷관리자 View 884 2025-04-10

KISTI 과학기술연구망센터는 내부 구성원의 AI 활용 역량 강화를 위하여 On-premise LLMs 포탈 구축을 구축하여 활용하고 있다.

LLM 서비스는 질문하는 분야에 따라 LLM 응답의 품질이 천차만별이기 때문에 여러 LLM 서비스를 동시에 사용하는 경우가 많다. 하지만 여러 LLM 서비스를 모두 구독하여 사용하기에는 비용의 문제가 발생한다. 예를 들어 ChatGPT, Claude, Gemini 3개 서비스를 구독하고자 하는 경우, 1개를 사용할 때 대비 3배의 비용을 지출해야 한다. 조직 구성원들의 LLM 서비스별 사용 패턴을 고려하지 않고 일괄적으로 팀 요금제로 구독하면 (LLM 서비스 수) x (팀원 수) 만큼의 비용이 발생한다. 서비스 사용량이 낮은 사람의 요금도 동일하게 부과되므로 과도한 비용 때문에 팀 단위 도입에 걸림돌이 된다.

KISTI 과학기술연구망센터는 종량제 LLM API 를 활용하여, 여러 모델을 골라서 사용할 수 있는 연구망 On-premise LLMs 포탈을 구축하여 2달 넘게 운영해 왔다. 해당 포털은 연구망센터 PC IP 대역에 한정하여 운영하였으며, 여러 모델을 동시에 사용할 수 있는 점 때문에 연구원들의 만족도가 매우 높았다. 사용량이 다양한 구성원이 동시에 사용을 하기 때문에, 사용량이 많은 유저(heavy user)가 존재하지만, 구성원 수 대비 생각보다 낮은 요금이 부과되었다. 또한 여러 종류의 모델을 사용하지만 하나의 포탈에서 각자의 계정으로 Chat Log가 관리되기 때문에 만족도가 높았다.

KISTI 과학기술연구망센터는 출연연 오픈소스 협의회에 참여하여 적극적으로 의견을 교류하고 있다. 본 활용사례는 1년여 전 오픈소스로 구축한 한국원자력연구원 인공지능응용연구실로부터 소개받은 사례이며, AI 활용 역량 강화를 위해 연구망센터에서도 구축하게 되었다. DeepResearch, MCP Agent 등 AI 기술과 용어가 범람하는 시대에, 연구망 활용기관들도 외부 AI 서비스 API 를 사용하고 운영중인 서비스에 녹여내는 경험이 필요할 것으로 생각된다. 그 첫 단추로 연구망 On-premise LLMs 포탈 구축 가이드를 공개하였다.

On-premise LLMs 포탈 구축 가이드 - https://wiki.kreonet.net/on-prem-llm-portal-guide-2025

본 문서는 다음과 같은 사항을 안내하고 있다.

1. 여러 LLM API 를 사용한 만큼 지불하도록 설정하는 방법을 안내한다.

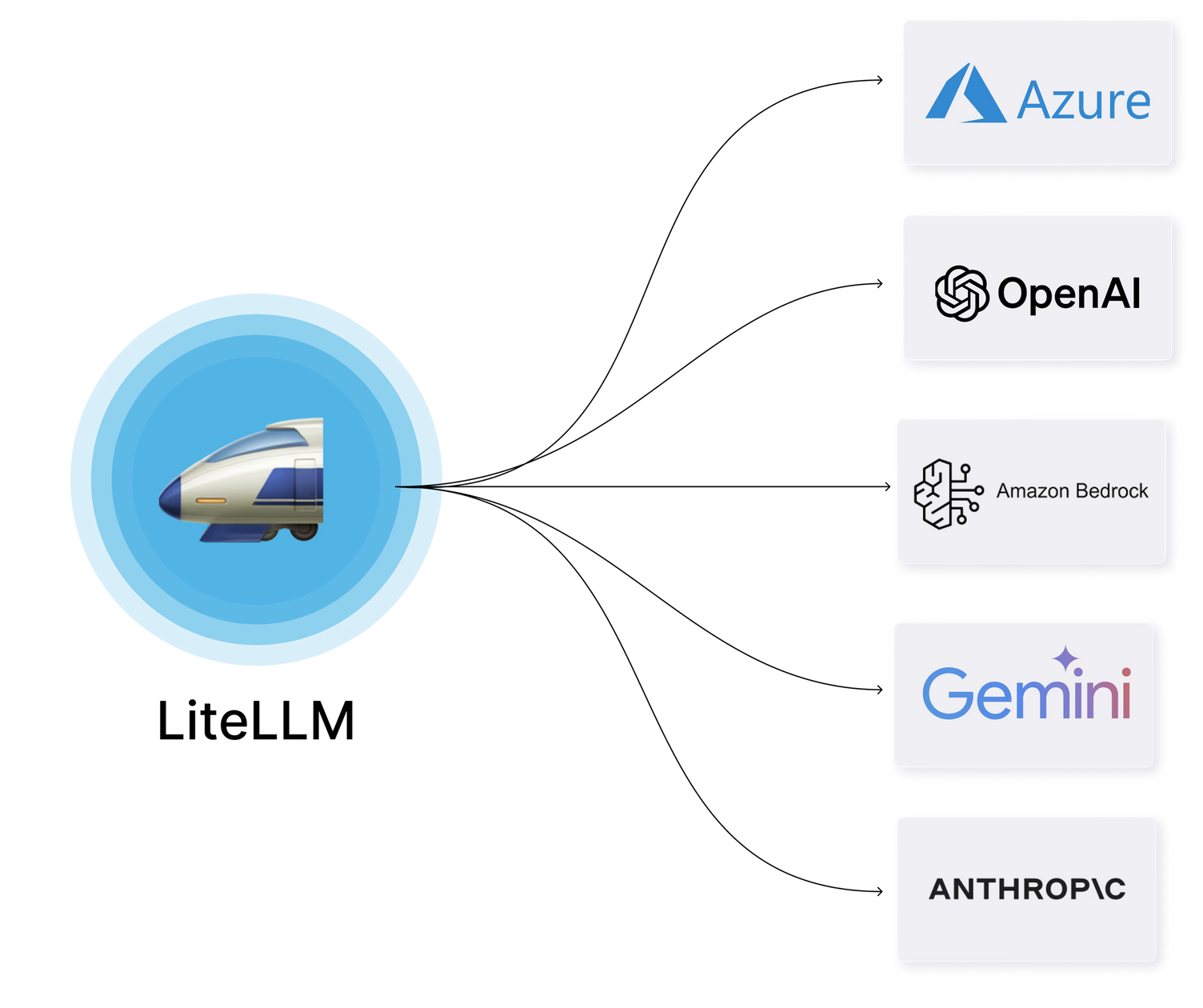

2. LiteLLM Proxy 를 통해 다양한 LLM API 를 통합하는 방법을 안내한다.

3. 통합된 API 를 호출하여 OpenWebUI 라는 하나의 웹 UI에서 여러 모델을 사용하는 방법을 안내한다.

본 가이드와 함께 연구망 활용기관의 AI 활용 역량이 한단계 발전하는 되는 계기가 되기를 바랍니다.